Large Model

2025-03-17

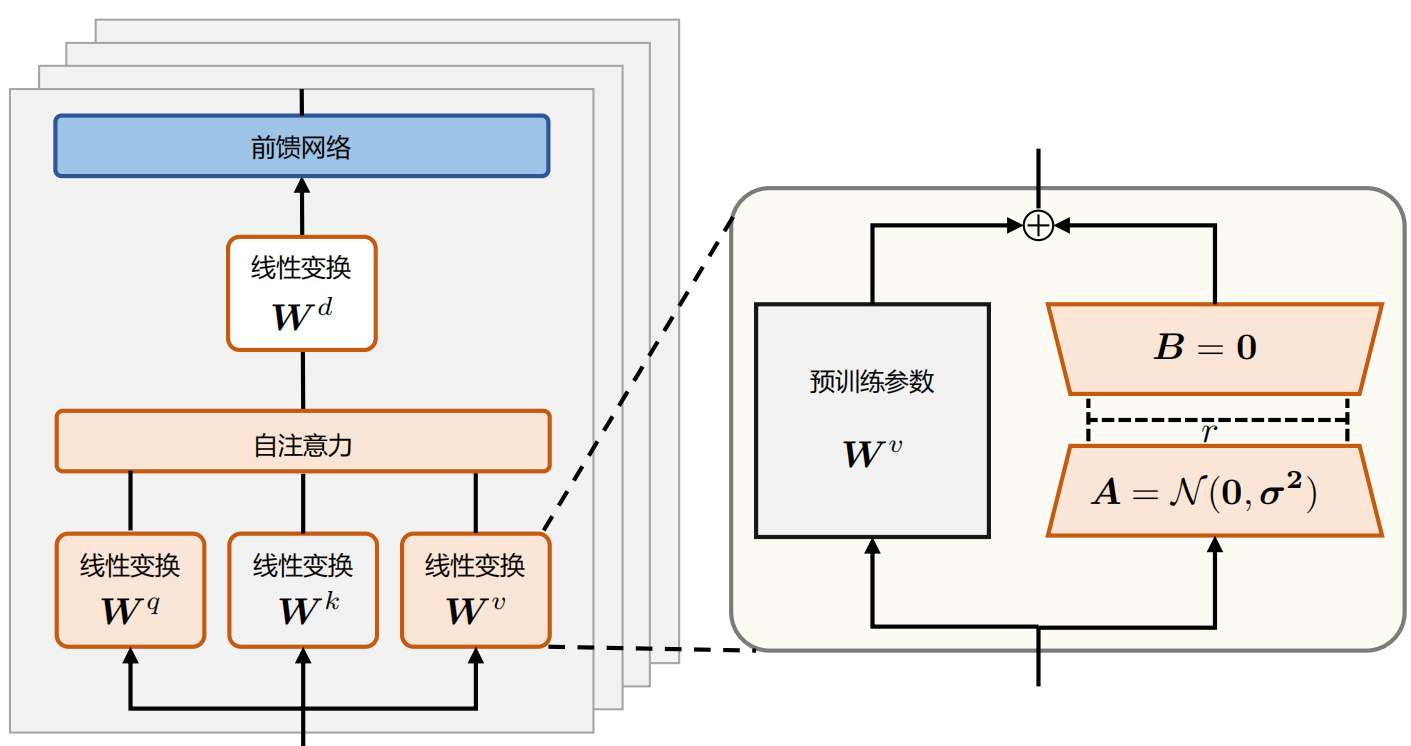

简介 后训练(posttraining)已成为完整训练流程中的重要组成部分。相比于预训练,后训练需要的计算资源相对较少,但能够: 提高推理任务的准确性 使模型与社会价值观保持一致 适应用户偏好 OpenAI 的 o1 系列模型首次引入了通过增加思维链(ChainofThought)推理过程长度来实现推理时间,扩展这种方法在数学、编程和科学推理等各种推理任务上取得了显著改进 研究界已探索多种方法来提高模型的推理能力:比如基于过程的奖励模型(Processbased Reward Models)强化学习(Reinforcement Learning), 代表工作:InstructGPT, 以及搜索算法(蒙特卡洛树搜索(Monte Carlo Tree Search)、束搜索(Beam Searc...