Seed-Thinking-v1.5

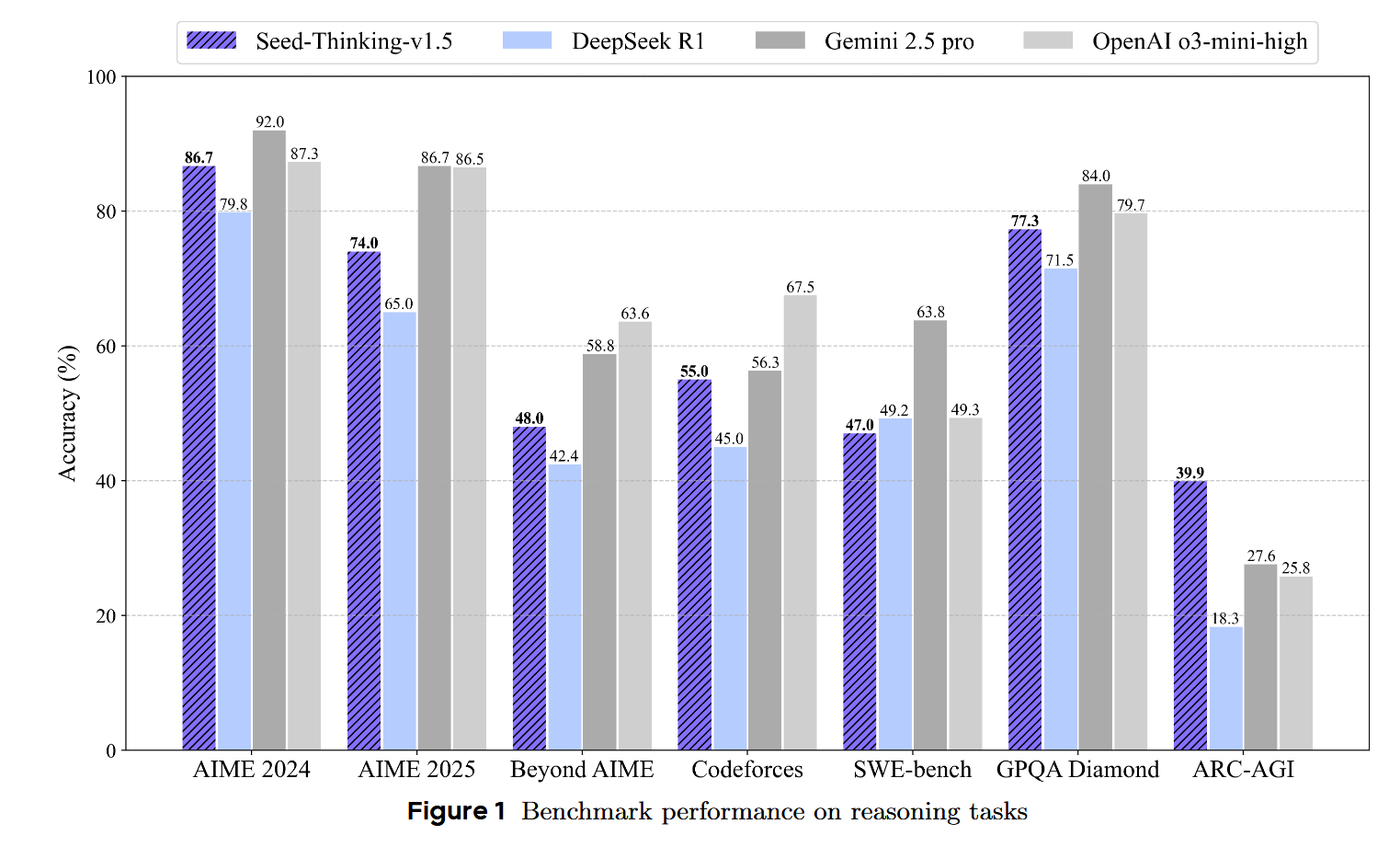

Seed-Thinking-v1.5 是 ByteDance Seed 团队开发的一个先进推理模型,采用 Mixture-of-Experts (MoE) 架构,具有 200B 总参数和 20B 激活参数。该模型的核心创新在于其"思考后回答"的机制,在数学、编程、科学推理等任务上取得了卓越的性能。相比DeepSeek R1 ,在很多数据指标上都取得了一定程度的进步。

数据

训练数据分为两大类:可验证问题(有明确答案)和不可验证问题(无明确答案)。模型的推理能力主要来自第一部分,并能泛化到第二部分。

可验证问题数据

可验证数据主要包含 STEM数据, 编程数据,以及逻辑推理数据

- STEM 数据

- 编程数据

- 逻辑推理数据

不可验证问题数据

这其中的数据主要包含需要基于人类偏好评估质量的非推理任务,涵盖 创意写作、翻译、知识问答、角色扮演等, Prompts来源于 Doubao-1.5 Pro 的 RL 训练数据

数据筛选策略:

- 去除低方差样本:使用 SFT 模型为每个提示生成多个候选, 使用奖励模型评分, 删除得分方差低的提示

- 去除过于简单的数据:

评分方法:采用成对奖励方法进行评分和 RL 训练,通过比较两个样本的相对质量帮助模型更好地理解用户偏好。

BeyondAIME 高级数学基准

作者也根据实际的需要,拓展了以下评测集(AIME):

- AIME 每年仅发布 30 道题目,样本量有限导致评估结果方差大

- 难以有效区分最先进的推理模型

构建过程:

- 与数学专家合作开发原创问题

- 系统性地改编现有竞赛问题,通过结构修改和场景重新配置

- 确保答案永远不是琐碎值(如问题陈述中明确提到的数字)

- 最终编制 100 道问题,难度等于或大于 AIME 最难问题

- 所有答案保证为整数(不限于特定数值范围)

奖励建模

奖励建模是 RL 的关键组件,定义了策略试图实现的目标。设计良好的奖励机制对于在训练阶段为模型响应提供精确可靠的奖励信号至关重要。

作者针对上面可验证性和不可验证性的数据划分分别设计了不同的奖励方式

可验证问题的奖励建模

这里作者也用了两种模型来进行reward model的建模

- Seed-Verifier:

- Seed-Thinking-Verifier:

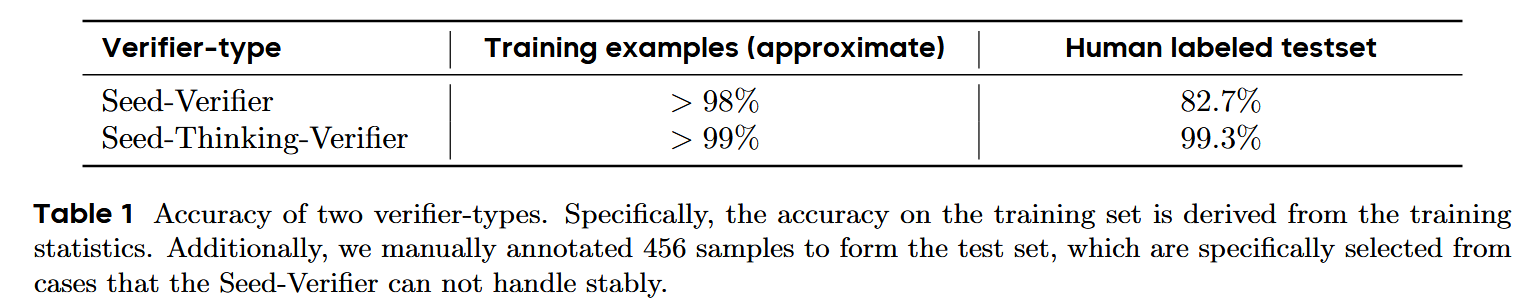

二者的性能指标对比如下表所示:

结果表明,Seed-Thinking 在某些特定情况下,处理起来比较困难和挣扎,而 Seed-Thinking-Verifier 表现出了出色的判断能力。尽管后者的思维过程确实消耗了大量的GPU资源,但作者认为,它产生的确切和强大的奖励结果对于赋予该政策具有强大的推理能力至关重要。

不可验证问题的奖励建模

对于不可验证的问题数据,作者采用了成对生成奖励模型(pairwise generative reward model)来评估两个响应的优劣,使用"YES"或"NO"的概率作为最终奖励分数。

训练数据与 Doubao 1.5 Pro 使用的人类偏好数据一致,主要包括创意写作和摘要等类别。

Pair-wise Reward Model

这里的奖励模型来源于文章 A Unified Pairwise Framework for RLHF: Bridging Generative Reward Modeling and Policy Optimization

目标和设计:评估两个响应( \(y\) 和 $ y^* $)联合,简化任务为相对的判断。

利用预训练的语言模型将比较构建成自然语言理解问题,如提示:“给定问题 \(q\) 和规则 \(R\),响应 $ y^* $ 是否优于 \(y\)?回答Yes/No。[MASK]”。其中, [MASK] 是在训练期间用“Yes”或“No”取代的地方。

这样做的优势在于

- 模型能够在评分时直接比较响应之间的相对差异,避免过度关注无关细节

-

奖励模型继承了Pretrain模型的上下文理解能力和语义生成能力,并加入了判别能力。

训练: -

使用词汇表上的softmax交叉熵损失进行训练。对于比较实例 \(\{(y_i, y_i^*)\}\):

- 通过以下方法解决位置偏差:

- 数据增强:生成成对样本,其中 \(y\) 在 \(y^{*}\) 之前和之后的样本都包含在同一个批次中。

- 引入均方误差(MSE)约束:

- 平衡这些损失的总训练目标: 其中 \(\zeta\) 平衡了权重,通常较小以保持一些位置差异信息。

训练方法

监督微调(SFT)

训练数据总计包含 400K个训练实例, 其中,300K个可验证问题(从 RL 训练集随机采样);100K个不可验证问题(来自 Doubao-Pro 1.5 的 SFT 数据)

CoT响应生成流程:

- 冷启动阶段:

- 迭代改进:

强化学习

作者开发了一个统一的增强学习框架,该框架无缝地融合了来自广泛领域的数据。其中包含三种数据类别:

- 可验证数据:从验证器获得反馈

- 通用数据:由奖励模型评分

- 混合数据:结合验证器和奖励模型的分数

在长CoT RLHF的背景下,遇到了一些挑战,例如价值模型偏见和奖励信号的稀疏性。而为了解决这些问题,作者利用了先前工作的关键技术,

这里的工作主要是以下三篇:

- Vapo: Efficient and reliable reinforcement learning for advanced reasoning tasks

- Dapo: An open-source llm reinforcement learning system at scale

-

What’s behind ppo’s collapse in long-cot? value optimization holds the secret.

这里只简单介绍一下这些关键技术: -

价值预训练(Value-Pretraining):

- 解耦 GAE(Decoupled-GAE):

- 长度自适应 GAE(Length-adaptive GAE):

- Clip-Higher:在 PPO 算法中,解耦上下裁剪边界:

- Token 级损失:

- 正例语言模型损失(Positive Example LM Loss):

- 在线数据分布适应:

Infrastructures

框架架构

核心设计:

- 使用 HybridFlow 编程抽象构建

- 在 Ray 集群上运行

- 数据加载器和 RL 算法在单进程 Ray Actor(单控制器)中实现

- 模型训练和响应生成在 Ray Worker Group 中实现

- 通过 SPMD(单程序多数据)在 Worker Group 内运行重型训练/生成工作负载

流式推出系统(SRS)

设计动机:长 CoT 生成中存在严重的掉队现象,不同提示的响应长度差异很大,导致生成期间大量 GPU 空闲时间

所以作者引入了流式推出以解耦模型演化和运行时执行

-

通过参数 \(\alpha\) 动态调整 on/off-policy 样本比率:

技术特点: -

动态精度调度:通过带误差补偿范围缩放的训练后量化部署 FP8 策略网络

- 三层并行架构:

- 内核自动调优器:基于实时负载监控动态选择最优 CUDA 内核配置

训练系统优化

并行机制:

- 组合 TP/EP/CP 与完全分片数据并行(FSDP)

- 对注意力层应用 TP/CP

- 对 MoE 层应用 EP