Introduction

目标检测中NMS需要依据候选检测目标的排序来进行筛选框,如果分类得分较低,但是定位框准确会导致在NMS中将该bbox框被排除掉,因此这个排序的可靠性就非常重要。之前的工作主要采用IOU分支(IOU-Net)与Centerness得分(FCOS)来作为大量候选检测的排序依据。

然而,本文认为这些方法可以有效缓解分类得分和物体定位精度之间的不对齐问题。 但是,它们是次优解的,因为将两个不完善的预测相乘可能会导致排名依旧变差,作者经过试验表明,通过这种方法实现的性能上限非常有限。 此外,增加一个额外的网络分支来预测定位分数并不是一个很好的解决方案,并且会带来额外的计算负担。

基于上述分析,作者提出:不采用预测一个额外的定位精确度得分(IOU-aware Centerness),而是将其merge进分类得分中。即预测一个可以同时代表目标存在和定位精度的定位感知或者IOU感知的分类得分。

Motivation

为了探索出候选框质量的排序依据和性能上限,本文以FCOS+ATSS为baseline,利用NMS之前的目标对应的gt真实值替换预测的分类得分,位置偏移和Centerness得分,并进行AP性能评估。 对于分类概率向量,有两种实现方法,在其gt标签位置的元素替换为一个1的数值,或者替换为预测框与gt框的IOU值。 除了gt真值之外,本文还考虑用gt IoU代替Centerness得分。

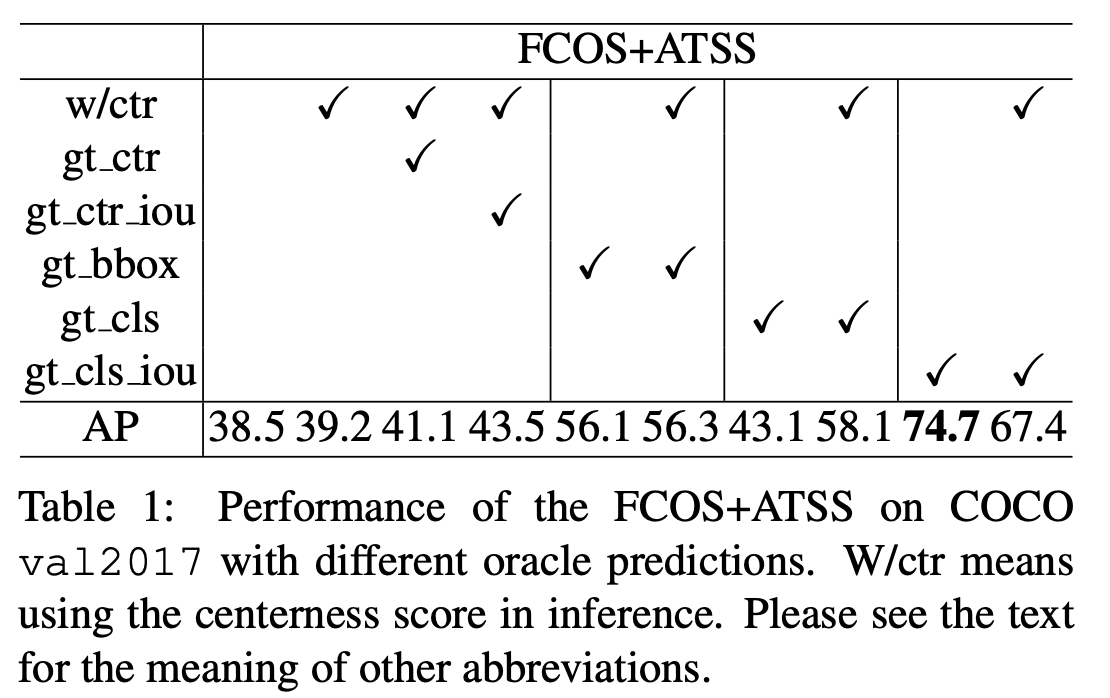

如表1中所示,看一下具体实验结果:

- baseline + centerness AP得分39.2

- baseline + centerness替换为gt_centerness,39.2->41.1

- baseline + centerness替换为gt_iou,39.2->43.5

这表明使用预测的IoU得分与分类得分的乘积对检测进行排序肯定无法带来显著的性能提升。centerness得分同样道理 - baseline+gt_bbox,39.2->56.1,这里直接把所有的groudtruth bbox放进候选检测?不是很懂

- baseline+gt_cls,即将gt位置的分类标签设置为1,这时候是否使用centerness将有明显区别,43.1 vs 58.1

- baseline+gt_cls_iou,将于gt的iou替换为5中的gt_cls,作为分类得分。直接74.7AP,加上centerness反而会降低到67.4AP

以上实验对比,具有更高IOU的候选检测是高质量的检测结果,这些结果表明IOU感知的排序策略(IACS)是最有效的选择方案。

VarifocalNet

IACS – IoU-Aware Classification Score

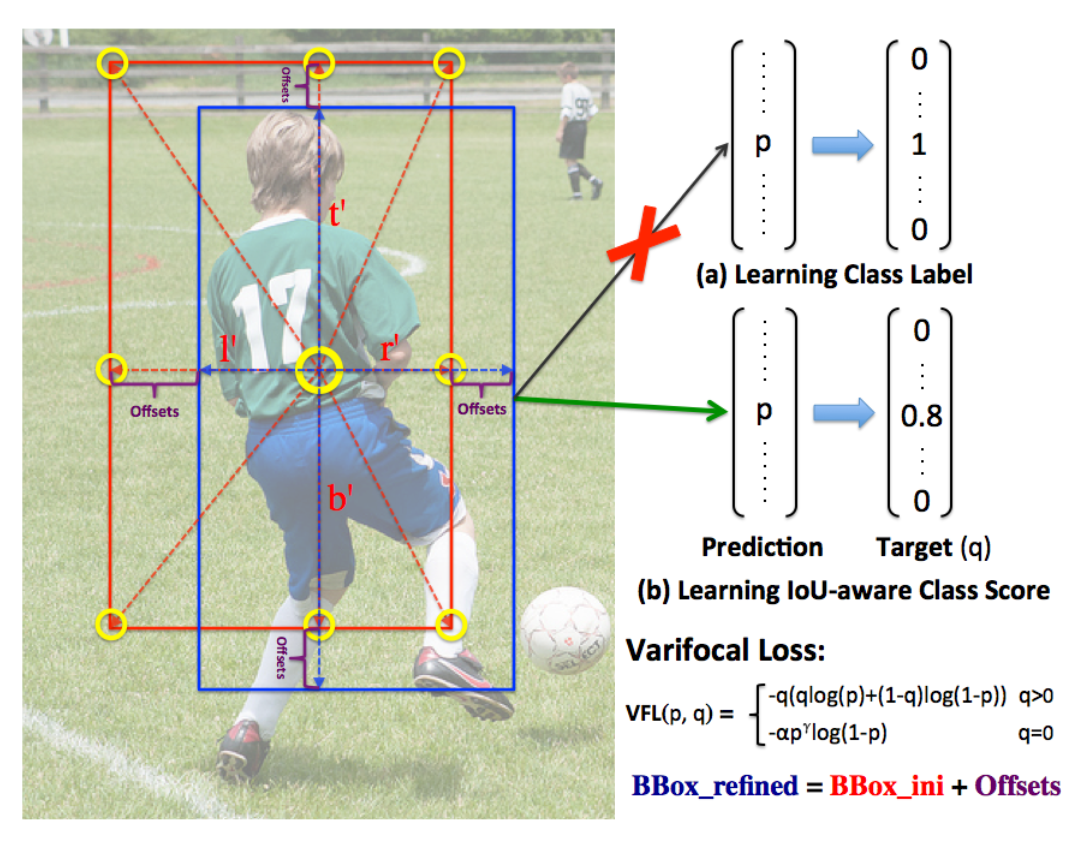

IACS定义为分类得分向量的标量元素,其中ground-truth类标签位置的值为预测边界框与其ground truth之间的IoU,其他位置为0。如上图所示,不是学习预测一个bounding box的类标签(a),而是学习IoU-aware分类得分(IACS)作为检测分数,融合了目标存在置信度和定位精度(b)。也就是motivation中实验分析的结果。

Varifocal Loss

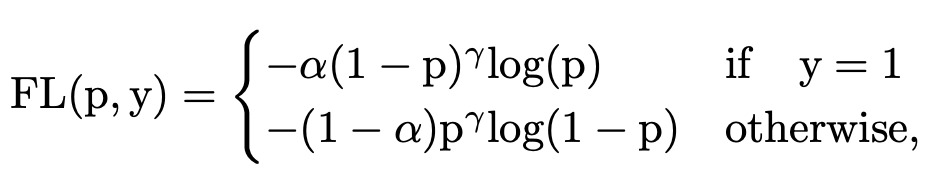

Focal loss定义:

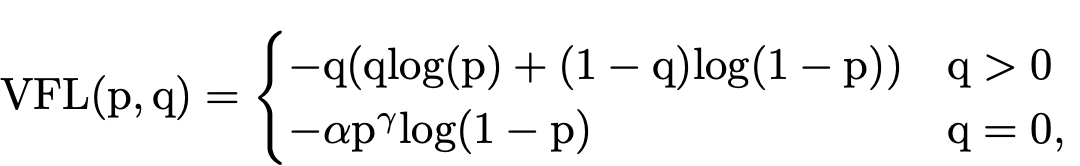

其中\(\alpha\) 是前景背景的损失权重,\((1-p)^{\gamma}\)和\(p^{\gamma}\)是不同样本的权重,难分样本的损失权重会增大。当训练一个密集的物体检测器使连续的IACS回归时,本文从focal loss中借鉴了样本加权思想来解决类不平衡问题。 但是,与focal loss同等对待正负样本的损失不同,本文选择不对称地对待它们。varifocal loss定义如下:

其中p是预测的IACS得分,q是目标IoU分数。 对于训练中的正样本,将q设置为生成的bbox和gt box之间的IoU(gt IoU),而对于训练中的负样本,所有类别的训练目标q均为0。

Varifocal Loss会预测Iou-aware Cls_score(IACS)与分类两个得分,通过\(p^{\gamma}\) 来有效降低负样本损失的权重,正样本选择不降低权重(因为与负样本相比,正样本已经算是稀有样本了)。此外,通过q(Iou感知得分)来对Iou高的正样本损失加大权重,相当于将训练重点放在高质量的样本上面。

Star-Shaped Box Feature Representation

在FCOS中,bbox与以往的(x,y,w,h)的box特征表达区域不同,预测出由(l’,t’,r’,b’)编码的4D向量,这表示从位置(x,y)到左,上,右和下侧边界框的距离。

再联想Deformable卷积的形式,FCOS的这种bbox编码方式可以很自然的与之结合,具体来说就是:选择以下九个采样点: (x,y),(x-l’,y),(x,y-t’),(x + r’,y),(x,y + b’),(x-l’,y-t’),(x + l’,y-t’),(x-l’,y + b’)和(x + r’,y + b ')。 然后将这九个位置映射到特征图上,并通过可变形卷积对投影点处的特征进行卷积以表示边界框。 由于这些点是手动选择的,因此没有额外的预测负担,因此这种新的表示形式具有很高的计算效率。

这种有效的星形边界框特征表示法,用于预测IACS。 它使用9个固定采样点的特征(图1中的黄色圆圈)来表示具有可变形卷积的边界框。 这种新的表示形式可以捕获包围盒的几何信息及其附近的上下文信息,这对于编码预测的bbox与gt box之间的不对齐问题是至关重要的.

Bounding Box Refinement

对于最初回归的边界框(l’,t’,r’,b’),首先提取星形表示形式对其进行编码。 然后,我们学习四个距离缩放因子(\(\Delta l,\Delta t, \Delta r, \Delta b\))来缩放距离矢量。最终表示为\((l, t, r, b) = (∆l×l’, ∆t×t’, ∆r×r’, ∆b×b’)\)

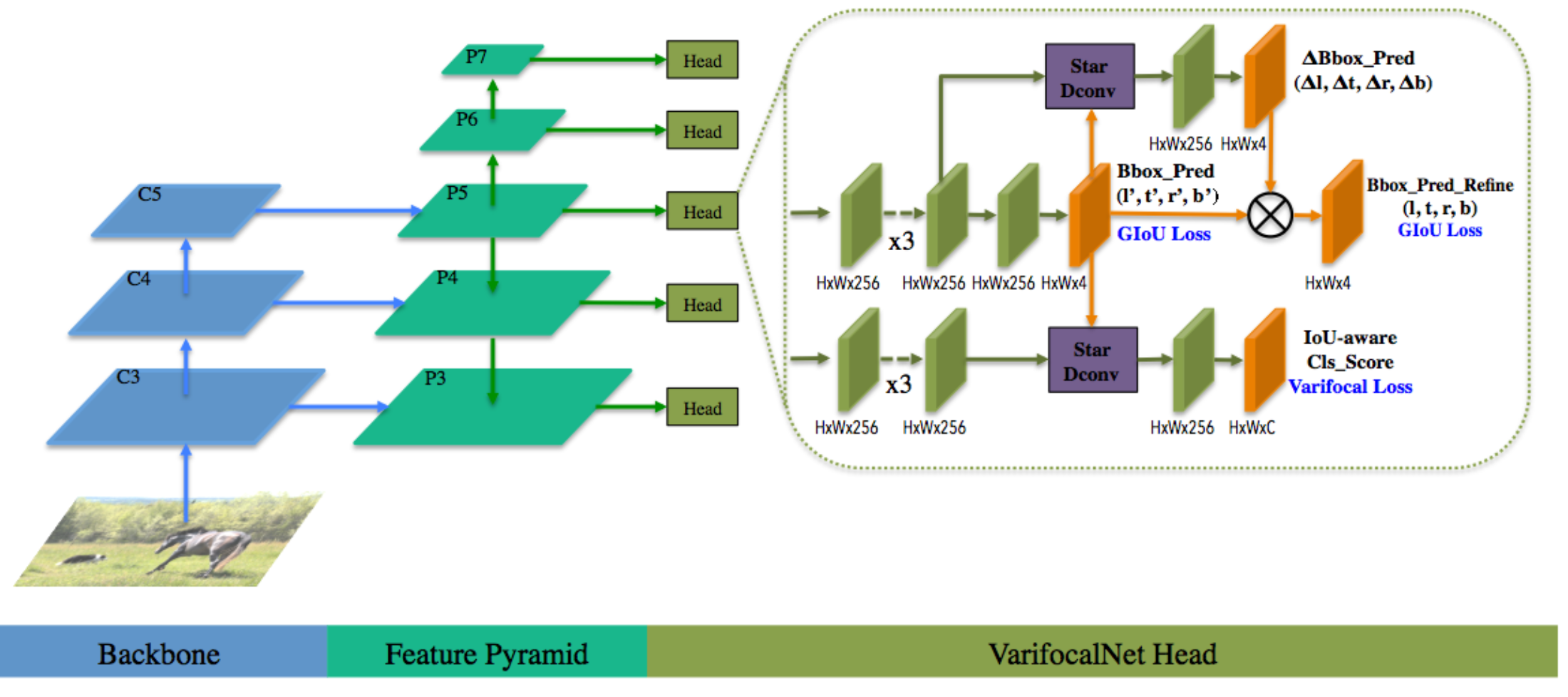

VariFocalNet

整体框架如下

VFNet的backbone由FPN构成(P3-P7), head部分分为两个分支网络,一支是为了回归最初的bbox并进行refine,另一支是为了预测iou-aware的分类score